Boostez votre visibilité Google !

Les différents algorithmes de Google

Sommaire

Qu’est-ce qu’un algorithme ?

Les algorithmes sont des traitements mathématiques appliquées aux pages web, une fois exécutés ils déterminent leur classement dans les pages de résultats. Google définit les algorithmes comme des « programmes informatiques conçus pour naviguer parmi des milliards de pages, y déceler les bons indices et vous renvoyer exactement la réponse à votre question ou à votre besoin. ». Les algorithmes établis par Google permettent de filtrer les résultats de recherches et donc fournir des informations et des résultats de haute qualité aux internautes utilisant ce moteur de recherche.

Quand les algorithmes de Google sont mis à jour, on parle de « Google Dance » car le classement des sites web sera modifié en fonction des nouveaux critères imposés par les nouveaux ou les mises à jours des algorithmes.

Aujourd’hui, on parle beaucoup d’une constellation d’algorithmes regroupant Pingouin, Panda, Colibri, Pigeon, Fred,… Découvrons ensemble à travers cet article toutes les spécificités des fameux algorithmes Google.

Les algorithmes de Google

1/ Google Vitesse : associé à la rapidité

Lancé en avril 2010, l Google Vitesse vise à favoriser les sites web rapides. Il est appliqué partout dans le monde.

2/ Google Caffeine : refonte du système d’indexation

Lancé en juin 2010, l. Cet algorithme vient résoudre un problème majeur de Google, qui était incapable d’indexer les pages qu’après extraction et analyse des contenus.

Caffeine augmente considérablement la rapidité d’indexation des pages ce qui permet à Google d’offrir des articles et des contenus plus récents.

3/ Google Panda : associé aux contenus

Lancé en août 2011, l’algorithme Panda est capable d’évaluer la qualité d’un site web en fonction de ses contenus. Visant principalement à améliorer la qualité des publications web et lutter contre le spam, Panda pénalise les sites publiant des contenus de faible qualité : contenus dupliqués (interne ou externe aux sites) et contenus faibles (peu pertinents ou en quantité trop insuffisante).

La mise à jour régulière de Panda permet aux sites pénalisés de récupérer leur référencement une fois leurs contenus améliorés. C’est grâce à cet algorithme assez performant que le contenu web s’est considérablement amélioré, facilitant ainsi les recherches des internautes.

4/ Google Fraicheur : associé à la fraicheur des contenus

Lancé en novembre 2011, l’algorithme Google Fraicheur fait partie des algorithmes favorisant les sites offrant des résultats frais et récents.

5/ Google Top Heavy : associé aux excès de publicités

Déployé en janvier 2012, l’algorithme Top Heavy est capable de pénaliser les sites surchargés en publicités (« ads above the fold » ou « top heavy »).

Pour ne pas être pénalisé par Top Heavy, il faut toujours éviter de surcharger ses pages web avec de la publicité. Cet algorithme a eu un très faible impact, à peine 1% sur les résultats de recherches Google.

6/ Google Pingouin : associé aux liens

Sorti en avril 2012, cet algorithme a été lancé pour Suite à une pénalisation par Pingouin, les webmasters doivent nettoyer les liens douteux pointant vers leurs sites, en les désavouant ou tout simplement en les faisant supprimer. Ceci afin de récupérer leur référencement lors de la prochaine mise à jour de Pingouin.

Depuis septembre 2016, la mie à jour 4.0 de Google Pingouin a été ajoutée dans l’algorithme cœur de Google pour rester actif en temps réel afin de ne plus devoir attendre les nouvelles mises à jour pour lever les pénalités.

7/ Google Pirate : associé au téléchargement illégal et violation des droits d’auteurs

Lancé en août 2012, Google Pirate est un filtre de recherche visant à supprimer les sites proposant du téléchargement de contenus illégaux ou ayant reçu des plaintes pour violation de droits d’auteurs, ainsi que les sites ayant

Pirate est régulièrement mis à jour pour protéger le contenu web et les droits d’auteurs.

8/ Google EMD (Exact Match Domain) – associé à la correspondance exacte du nom de domaine

Lancé en septembre 2012, l’algorithme Exact Match Domain permet d’exclure des premiers résultats de recherche Google tous les sites non référencés et ayant des contenus de faible qualité. Ces sites ne doivent pas être affichés dans les premiers résultats même si leurs noms de domaine correspondent à des requêtes fortement recherchées.

Le nom de domaine contribue au référencement des sites et certains webmasters en ont profité en créant des noms de domaine optimisés à outrance et des pages web de faible qualité. Heureusement que Google EMD (Exact Match Domain) est là pour lutter contre ces pratiques !

9/ Google Payday : associé au spam

Sorti en juin 2013, l’algorithme Google Payday assure la qualité des pages web en excluant tous les résultats assimilés au spam comme les sites des casinos, le contenu pornographique, contrefaçon, crédit, etc.

10/ Google Colibri (Hummingbird) : pour améliorer la compréhension des requêtes

Google Colibri fait partie des algorithmes les plus importants de Google. Lancé en septembre 2013, cet algorithme a considérablement amélioré les résultats de nos recherches sur Google en les rendant plus précises et rapides.

C’est grâce à Colibri que Google est devenu capable de comprendre les requêtes et de fournir des résultats de recherche de qualité et des réponses précises telles que « quel est le restaurant le plus proche », « quelle est la pharmacie de garde ce week-end ? », etc.

L’algorithme Google Colibri n’est qu’un premier petit pas vers le développement de l’intelligence artificielle.

11/ Google Pigeon : associé à la recherche locale

Lancée en juillet 2014, Pigeon est un algorithme de classement des résultats locaux. C’est la solution indispensable pour les business locaux comme les médecins, les restaurants, les bars, les salons de thé, les artisans, etc.

12/ Google HTTPS : associé à la sécurité

Officialisé en août 2014, l’algorithme HTTPS favorise les sites internet basés sur le protocole de sécurité HTTPS. Son but est de garantir une expérience de navigation sécurisée.

Ce n’est qu’en 2017 que Google impose réellement ce certificat à tous les sites internet. Depuis 2017, tout site web non sécurisé par un certificat SSL (HTTPS) est affiché comme « non sécurisé » sur les différents navigateurs.

13/ Google Mobile Friendly : associé à la compatibilité mobile

Dans le but d’accorder une grande importance aux sites compatibles avec les mobiles, Google a annoncé en avril 2015 le lancement de son algorithme Mobile Friendly. Cet algorithme privilégie le référencement des sites web ayant des versions mobiles et compatibles aux smartphones et aux tablettes.

Mobile Friendly prend en compte la compatibilité des sites avec les mobiles comme critère de référencement.

14/ Google Phantom (Quality) : associé à la qualité des contenus

Sorti en mai 2015, Google Phantom fait partie des algorithmes d’évaluation du contenu web. Lorsque les webmasters ont ressenti des changements, ils se sont tournés vers l’équipe de Google en charge de la qualité des moteurs de recherche, mais ceux-ci ont répondu qu’ils n’avaient aucune mise à jour à annoncer… Les webmasters convaincus que quelque chose se produisait au niveau des classements des sites webs, ont nommé cet algorithme Google Phantom en raison du manque de communication de Google.

Quelques semaines plus tard, Google avoua qu’une mise à jour avait bien été déployée et qu’elle portait sur la qualité du contenu des sites web, comme Google Panda. La mise à jour Phantom fut alors rebaptisée Quality par Google.

Comme Panda, Phantom vise à améliorer la qualité des publications web en pénalisant les sites publiant des contenus de faible qualité afin de lutter contre le spam.

15/ Google Pages satellite : associé aux contenus « satellites »

Mis en ligne en mai 2015, Google Page satellite, comme son nom l’indique, est un algorithme visant à pénaliser les pages satellites qui sont de très faible contenu ou de contenu dupliqué et créés uniquement pour le SEO. Cet algorithme vise aussi à pénaliser les techniques de sites satellites.

16/ Google Rankbrain : associé à l’intelligence artificielle

Sorti en octobre 2015 et basé sur les techniques d’intelligence artificielle, Rankbrain fait partie de l’algorithme de recherche Colibri.

Rankbrain est capable de comprendre les requêtes des internautes et même de faire la reformulation des mots clés pour offrir des résultats précis. Cet Algorithme de Google est capable de comprendre la sémantique des textes et donc d’interpréter les recherches les plus abstraites et les plus complexes des internautes, c’est pour cette raison qu’il fait partie des facteurs de référencement les plus importants. Il est devenu très important d’optimiser sémantiquement ses contenus textes.

17/ Google Publicité interstitielle intrusive : associé à la publicité

Google Publicité interstitielle intrusive fait partie des algorithmes visant à pénaliser les sites présentant trop de pop-up ou bannières interstitielles. L’impact de cet algorithme, lancé en janvier 2017, se situe page par page ce qui permet d’éliminer tout ce qui peut causer des problèmes de lecture des contenus web.

18/ Google Fred : associé à la qualité globale

Fred fait partie des nouveaux algorithmes de Google. Lancé en mars 2017, cet algorithme reste à ce jour un vrai mystère. Certains webmasters pensent que Fred pénalise les sites construits seulement pour la monétisation, sans contenus de qualité ni optimisation SEO.

Quel que soit le mode de fonctionnement de cet algorithme, on est sûr qu’il apportera satisfaction en luttant contre les abus de backlinks, les publicités et en améliorant les résultats de recherches.

Personnellement, j’ai remarqué que Google Fred pénalisait les sites sur-optimisés au niveau des ancres des liens retours, ainsi que les sites intégrant des contenus de trop faible qualité, tel que le drop-shipping. Donc Google Fred serait un mélange de Google Panda et Google Pingouin !

19/ Google EAT : expertise, autorité et confiance

Grosse mise à jour de l’algorithme de Google, qui a eu lieu en août 2018. Cette mise à jour a été nommée « medic update » dans un premier temps, car elle touchait principalement les thématiques santé et la finance du type YMYL (Your Money Your Life : votre argent votre vie), malgré que Google ait dit publiquement que cela n’était pas la cible de cette mise à jour.

Les pages YMYL sont des contenus destinés à influencer la santé, les finances et la sécurité des utilisateurs. Exemples de pages YMYL :

- Thématiques médicales, associées à la santé, les maladies et la nutrition

- Thématiques financières sur l’investissement, les placements, les impôts, les achats immobiliers, les assurances

- Thématiques juridiques tels les testaments, le divorce et la garde d’enfants

- Thématiques liées aux transferts d’argent

Pour rester sous les radars de Google, ces pages doivent être irréprochables, les contenus doivent être complets, exacts et maintenus à jour. Le site qui héberge ces contenus doit également être conforme et professionnel.

Mon avis sur cette mise à jour Google :

Personnellement, je ne crois pas trop à cette mise à jour orienté « medic update ». Avec du recul, ce que je remarque, c’est que Google donne moins d’importance et de confiance aux sites qui manquent de crédibilité.

Cette mise a jour doit se nommer EAT : Expertise + Autority + Trust (expertise + autorité + confiance).

Pour résumer la mise à jour Google EAT :

- C’est une réelle évolution du core de l’algorithme de Google

- C’est une mise à jour associée à RankBrain, du machine learning, qui favorise les cocons sémantiques et les pages optimisées sémantiquement

- Cette mise à jour va pénaliser les sites peu crédibles, qui n’ont pas d’écho-systèmes autour d’eux

Comment anticiper cette mise à jour et les prochaines ?

- Votre site doit proposer du contenu de qualité, vous devez mettre en avant votre expertise dans votre domaine, vos années d’expérience, proposer des contenus pertinents.

- Votre site doit être populaire. Il doit générer de l’autorité dans votre milieu, ce qui doit automatiquement faire parler de vous. Vous devez être une référence dans le milieu.

- Votre site doit inspirer de la confiance ! Cela doit être un site professionnel, rassurant pour les visiteurs, sécurisé et en conformité.

- Vous devez mettre en place une stratégie éditoriale cohérente, tout en partageant votre expertise.

- Votre site doit recevoir des liens depuis des sites de confiance, mais il doit aussi envoyer des liens vers des sites d’autorité, experts dans le milieu.

- Mettez en place une page Google My Business.

- Vous devez être cité et avoir des liens en provenance des réseaux sociaux, le but est de créer du bruit autour et en dehors de votre site web.

- Pour plus de crédibilité : écrivez un livre, donnez des conférences, participez à des interviews…

Google amorce un grand virage avec EAT, pour moi, il va continuer dans ce sens, donc à vous d’anticiper cela pour le futur ! Commencez à travailler et à renforcer votre expertise, votre autorité et votre confiance… Pour en savoir un peu plus, je vous invite à lire cet article et à écouter la vidéo de la table ronde à laquelle j’ai participé.

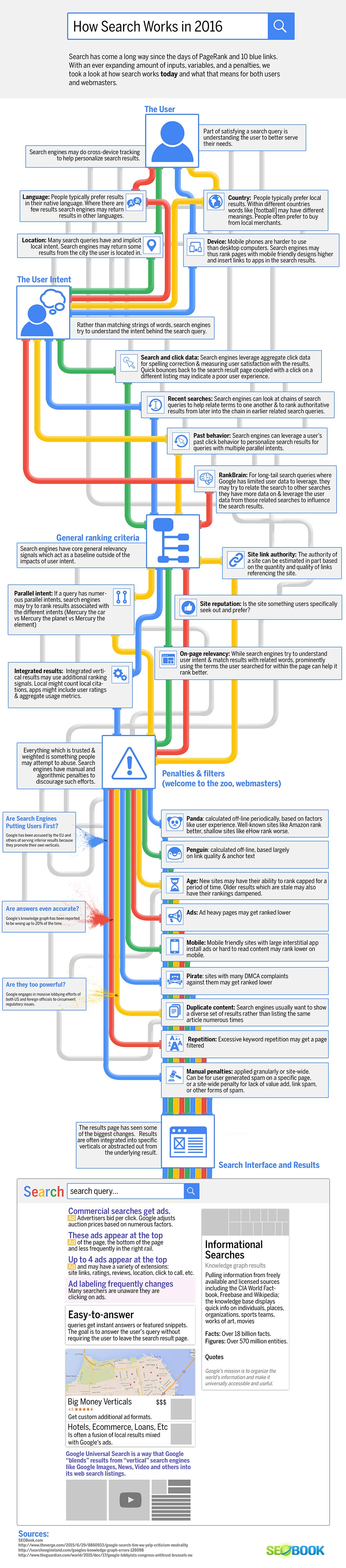

Infographie sur le fonctionnement de Google

Cet article vous a plu ? Un petit partage... Merci !

[juiz_sps buttons="facebook, twitter, linkedin, pinterest"]

N’hésitez pas à donner votre avis